29

juil.

2008

A part classer les chercheurs ou les universités le dimanche, la bibliométrie sert aussi à comprendre la structure d'une discipline ou de la science en général. C'est pour cela qu'elle fait partie de la boîte à outil de cette "science de la science" qu'est la scientométrie. Notamment pour mieux cerner les mathématiques, une science décidément à part.

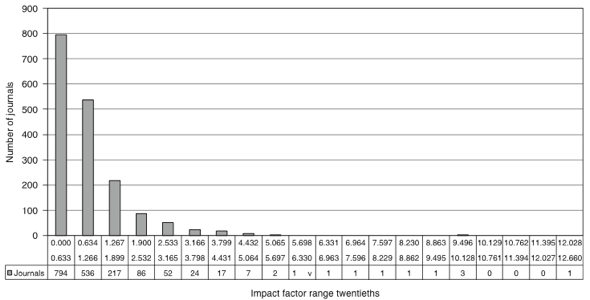

Tout commence avec un article récent de Stephen J. Bensman, truffé de statistiques, qui analyse la différence de distribution des citations dans les revues de "science dure" et les revues de sciences humaines et sociales en 2005. Il constate notamment qu'en sciences dures, la distribution est binomiale négative tandis qu'elle est de type Poisson en sciences sociales. Concrètement, cela signifie que la distribution est beaucoup plus aléatoire dans ce second cas : la vaste majorité des revues de sciences sociales se répartissent quasi-uniformément entre les trois premiers 20-quantiles (histogramme ci-dessous), alors que 82% des revues de science dure sont concentrées dans le premier 20-quantile.

Dans les deux cas en tous cas, les distributions sont extrêmement asymétriques. La majorité des articles sont pas ou peu cités, et donc les facteurs d'impact décollent difficilement de zéro. On peut dès lors s'intéresser aux quelques revues les plus citées, celles qui traduisent d'autres comportements distinctifs de leur champ. Ainsi, on constate que chaque numéro des 64 revues les plus citées en science dure a une probabilité de 75% de contenir un article de synthèse (review article), contre 7% dans les 60 revues à fort facteur d'impact en sciences sociales. Il ne fait aucun doute que les sciences sociales utilisent beaucoup moins l'article de synthèse, dont la fonction est d'établir des consensus, préludes à la cristallisation de paradigmes. On touche là en effet à une différence de fonctionnement entre les deux champs : on considère généralement que les sciences sociales sont organisées en "écoles de pensée", co-existant les unes à côté des autres, parfois depuis des décennies (bourdieusiens, marxistes…) tandis que les sciences dures avancent dans une unique direction, jalonnée par des articles de synthèse, en faisant peu appel à la littérature plus ancienne qu'une dizaine d'années. Au sein des sciences sociales, on peut cependant distinguer la psychologie et les sciences du comportement, qui se comportent plutôt comme des sciences dures avec une forte asymétrie et de nombreux articles de synthèse !

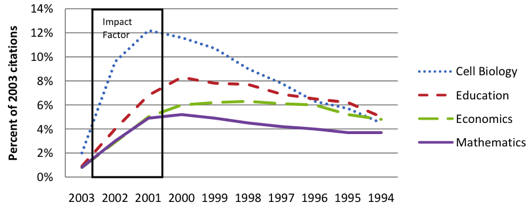

Mais qu'en est-il des mathématiques ? Ce n'est encore qu'une intuition mais le même Stephen Bensman suggérait sur une liste de diffusion qu'elles ressemblent plus aux sciences sociales qu'aux sciences dures. Le facteur d'impact des revues de mathématiques est compris entre 0,108 et 2,739, soit un écart très restreint, et les revues les plus citées ne contiennent aucun article de synthèse. On reconnaît les signes d'une loi de distribution des citations extrêmement aléatoire et de l'absence de développement de paradigmes consensuels. Qui plus est, le graphique ci-dessous extrait d'un rapport de l'International Mathematical Union (IMU) montre bien que l'obsolescence des articles en mathématiques est extrêmement lente, voire inexistante, bien loin de la biologie cellulaire. Encore l'indice d'une science sociale.

Certes, on pourrait reprocher aux critères utilisé leur pauvreté. Mais sous cet angle toutefois, l'hypothèse semble bien tenir la route… Surtout, il en découle une conséquence directe : comme en sciences sociales, cela ne fait aucun sens d'évaluer les mathématiciens par des indicateurs de citation. En effet, qui dit absence de paradigmes faisant consensus dit impossibilité d'évaluer un chercheur de façon mécanique. Plutôt que d'avoir affaire à des chercheurs bons ou mauvais dans un paradigme donné, on a affaire à des chercheurs travaillant dans des paradigmes différents et donc impossibles à comparer entre eux. L'analyse des citations, surtout dans un intervalles aussi petit, ne nous apprend quasiment rien. Pour preuve, la corrélation entre l'évaluation par les pairs des écoles doctorales mené en 1993 aux Etats-Unis par le National Research Council et les citations obtenues par chaque faculté n'est que de 56% en mathématiques. A comparer, par exemple, avec les 81% de la chimie ou les 70% de la physique !

Derniers commentaires